在全球AI開發需求持續爆發的背景下,算力資源的獲取方式與使用效率直接影響技術創新的進程。GpuGeek作為專注于AI基礎設施服務的平臺,憑借其硬件覆蓋廣度、功能設計深度與全球資源協同能力,為中小企業、個人算法工程師及高校師生提供了差異化的解決方案。本文基于官方披露的核心能力數據與功能特性,解析其成為多類型用戶首選平臺的關鍵原因。

一、硬件資源:全梯度覆蓋,滿足多場景算力需求

GpuGeek在GPU類型與規模擴展上的優勢,精準匹配了不同用戶的硬件需求層級:

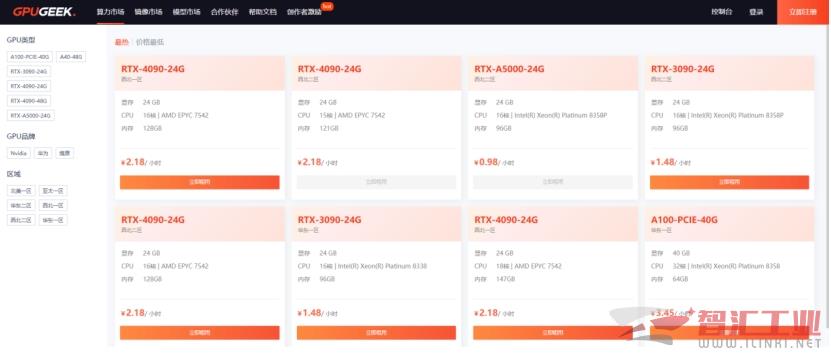

從單卡到集群:GpuGeek平臺提供消費級RTX 4090/3090、專業級A5000/A800及尖端H100集群,覆蓋模型微調、大規模訓練、實時推理等全場景。

彈性算力調度:用戶可隨時調整GPU卡數,支持1-8卡并行計算(如8卡A800集群達5.2 TFLOPS FP64性能),無需重新配置環境即可切換算力規模。

成本精細控制:GpuGeek提供秒級計費服務,同時配合周期性活動(3月A5000 24G GPU限時0.98元/時),使個人用戶和中小團隊能低成本啟動項目。

綜上,高校團隊可使用單卡RTX 4090完成課程實驗,中小企業可通過4卡A800集群訓練垂直領域大模型,科研機構可運用H100集群攻堅千億參數模型。

二、部署效率:30秒極速啟動與跨國協作優化

GpuGeek平臺通過技術架構創新,攻克傳統云計算的兩大效率瓶頸:

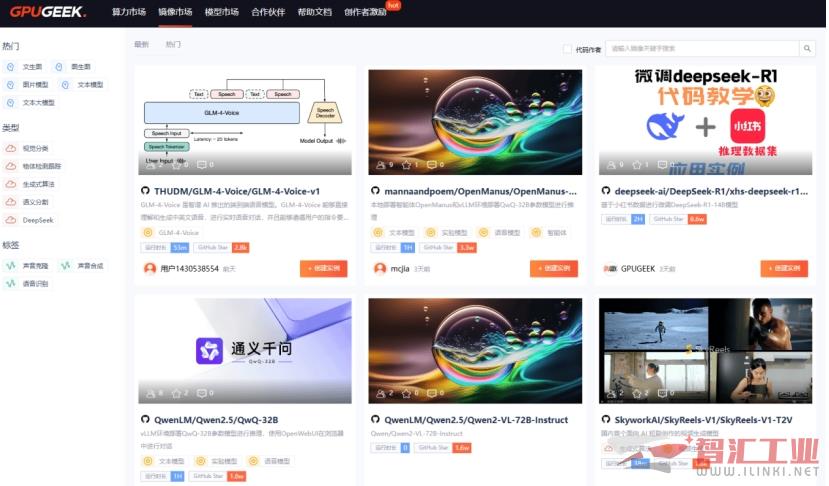

全流程極簡操作:用戶從注冊賬號到創建實例最快僅需30秒,GpuGeek內置OpenManus、阿里千問QwQ-32B等100+預加載模型鏡像,用戶免除復雜環境配置直接使用。

跨國部署零延遲:香港、達拉斯等海外節點實現鏡像秒級下載,推理延遲穩定≤0.5秒,數據合規性配置一鍵完成。

存儲性能突破:模型文件預載至本地NVMe硬盤,讀取速度提升3-5倍,單日可支持超20次訓練迭代。

三、開發者支持:從工具鏈到生態的全維度助力

GpuGeek構建了完整的AI開發支持體系,顯著降低技術門檻:

開箱即用工具鏈:GpuGeek預置TensorFlow/PyTorch/PaddlePaddle框架,集成在線IDE與API接口,支持動態創建/刪除GPU容器實現資源彈性伸縮。

開放共享生態:GpuGeek近期推出了三大活動,個人用戶可通過邀請好友注冊并充值,及發布鏡像等活動賺取推廣金或積分獎勵。

數據與算力協同:平臺提供開源數據集庫,支持用戶貢獻創作內容并獲得算力金,形成“數據-訓練-部署”閉環。

四、企業級服務:安全架構與全球節點的雙重保障

針對企業用戶的特殊需求,GpuGeek提供了專業級支持方案:

混合部署能力:GpuGeek支持企業將敏感數據存儲在湖北、宿遷、慶陽等國內節點,訓練任務分發至香港節點利用低價算力,通過API實現跨域資源調度。

安全增強設計:GpuGeek基于kata虛擬化技術實現runV容器隔離,防止多租戶資源沖突,且滿足合規要求。

精準定位技術普惠的AI基礎設施

相較于傳統云服務商,GpuGeek在硬件種類豐富性(多種類GPU可選)、功能垂直深度(專為AI訓練優化)、成本控制精度(秒級計費)三個維度建立顯著優勢。隨著OpenManus等生態項目的持續推進,其正從單純的算力供應商進化為AI開發者的全周期合作伙伴。選擇GpuGeek,不僅是選擇云計算平臺,更是選擇一種更高效的AI創新范式。

(審核編輯: 光光)

分享