曾經,基于模型的強化學習(MBRL)提出了SOTA-PLANET,目前Google AI 與 DeepMind 聯合推出了 Dreamer,這是一種從圖像中學習模型并用它來學習遠見性(long-sighted)行為的 RL 智能體。通過模型預測的反向傳播,Dreamer 能夠利用它學得的模型高效地展開行為學習。通過從原始圖像中學習計算緊湊模型狀態,Dreamer 僅使用一塊 GPU 即可以高效地從預測到的并行序列中學習。

Dreamer的基本架構

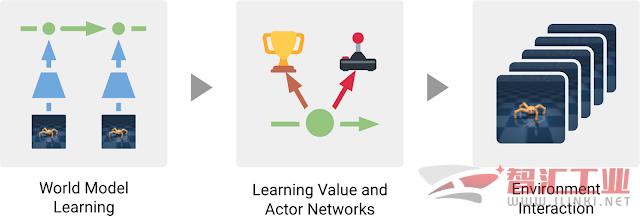

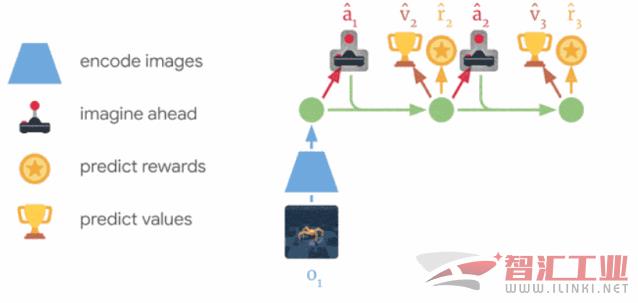

Dreamer和典型的基于模型方法一樣包含三個過程:學習世界模型、基于世界模型的預測學習行為、在環境中執行學習到的行為來收集新的經驗。為了學習行為,Dreamer中利用價值網絡(value network)將規劃視野外的獎勵納入考量,同時利用行為網絡(actor network)來高效的計算行為。這三部分可以并行地執行,一直重復運行直到達成目標:

Dreamer主體的三個過程,世界模型基于過去經驗學習,隨后基于這一模型預測,主體通過價值網絡來預測未來獎勵、行為網絡來選擇行為。行為網絡用于與環境交互。

學習世界模型

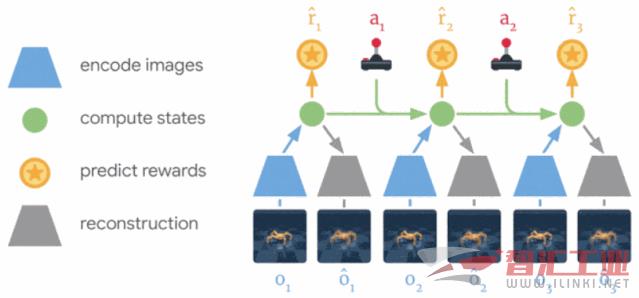

Dreamer采用了PlaNet的世界模型,通過一系列緊致的模型狀態來預測輸出,而這些模型狀態則通過輸入圖像計算得到,而不是直接利用圖像來進行處理。它將自動學習得出代表有益于預測未來輸出概念的模型狀態,例如目標類型、位置以及目標與周圍環境的交互等等。給定數據集中一個過去的圖像、行為和獎勵序列,Dreamer按照下圖的方式進行世界模型的學習:

Dreamer 從經驗中學習世界模型,利用過去的圖像(o1–o3)、行為(a1–a2),它將計算出緊致的模型狀態(綠色圓),并可以基于這些狀態重建出圖像并預測出獎勵。

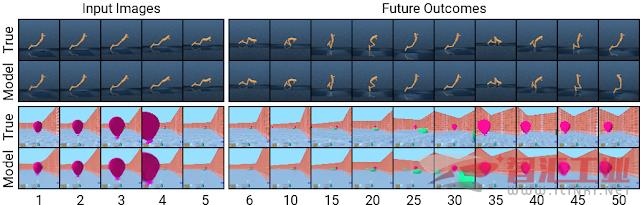

利用PlaNet世界模型的優勢在于利用緊致的模型狀態代替了圖像來進行預測,極大地提高了計算效率。這使得模型可以在單個GPU上預并行的預測上千個序列。這種方式同時可以提高模型的泛化性,進行精確的長時視頻預測。為了更好地理解模型的工作原理,下圖展示了將預測序列模型狀態解碼回圖像的結果:

復雜環境下的長程預測結果,上圖顯示了兩個主體未曾遇到過的序列,給定五張輸入圖像,模型對其進行重建并預測出了后續到50步的圖像結果。

高效行為學習

先前基于模型的主體選擇行為的方法分為兩種,要么通過多個模型預測來進行規劃,要么通過將世界模型代替模擬器來復用無模型方法的技術。但兩種方法都需要龐大的計算需求,同時也未充分利用學習到的世界模型。此外及時強大的世界模型也會受制于精確預測的長度,很多先前基于模型的主體表現出短視的缺點。Dreamer通過世界模型的預測進行反向傳播學習價值網絡和行為網絡來克服上述局限。

Dreamer通過預測的狀態序列反向傳播獎勵來高效地學習行為網絡用于預測正確的行為,這在無模型方法中是無法實現的。這將告訴Dreamer其多小的行為變化將會影響未來預測的獎勵,使得它可以向最大化獎勵的方向上優化行為網絡。為了考慮預測范圍外的獎勵,價值網絡將估計每一個模型狀態未來的獎勵和,獎勵和價值將反向傳播來優化行為網絡去改善行為。

Dreamer通過模型狀態預測序列來學習長程行為,首先學習每個狀態的長程價值,而后通過反向傳播到行為網絡來預測能夠得到高價值和獎勵的行為。

Dreamer與PlaNet有諸多不同,在環境中的給定狀態下,PlaNet在不同行為序列的多個預測中搜索最佳行為,而Dreamer則避開了這種計算消耗巨大的搜索方式,利用規劃和行為解耦的方式來提高計算效率。一旦在預測序列上訓練好了行為網絡,它將計算與環境交互的行為而無需額外的搜索。此外Dreamer利用價值函數考慮到了規劃以外的獎勵并通過反向傳播提高了規劃的效率。

控制任務上的表現

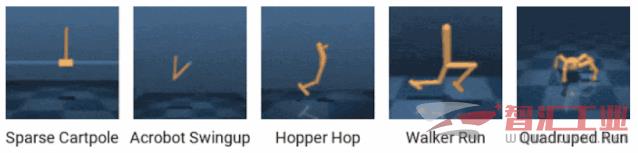

為了測試Dreamer的性能,研究人員在20個不同的任務上對其進行了測評,包括平衡、控制、運動等多種復雜的強化學習任務。

多種復雜的任務,其輸入為圖像。包括了碰撞、稀疏獎勵、混沌動力學和高自由度甚至三維視角等復雜情況。

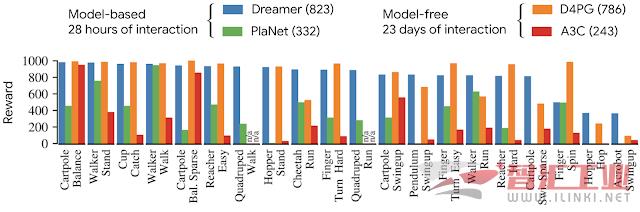

研究人員將Dreamer與多個先進的模型進行了比較,包括先前最先進的基于模型的方法PlaNet、無模型方法A3C、結合多種先進手段的無模型方法D4PG。實驗表明,基于模型的主體可以在五百萬幀內完成高效學習,大概對應28小時的仿真,而無模型的方法則需要近100萬幀的學習,大概對應23天的仿真訓練。在20個任務的測評基準上,Dreamer領先于目前最先進的無模型方法D4PG(平均分823>786),同時其與環境的交互大概要少二十倍。此外它最終的結果在所有任務上也超過了先前最好的基于模型方法PlaNet,最終的結果如下圖所示:

Dreamer的性能與其他方法的比較,其得分、數據效率和計算時間都比先前方法要好。

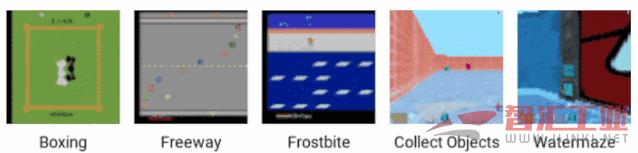

此外研究人員還在連續任務上進行了實驗,以驗證Dreamer面對復雜環境的能力。下面的任務需要不僅需要長程行為預測,同時還需要模型具有空間感知能力。實驗表明Dreamer對于這些更具挑戰的任務依然能夠很好地進行處理:

Dreamer成功地在雅達利游戲和DeepMind環境中運行,這些離散的任務更具挑戰性。

Dreamer不僅在性能上超越了原有基于模型的方法,同時在計算效率上也大幅提升。研究人員認為Dreamer將為強化學習提供更為堅實的發展根基,同時也將促進更好地表示學習、基于不確定性的方向探索、時域抽象和多任務學習的發展。

(審核編輯: 智匯小新)

分享